在2002年《萨班斯-奥克斯利法案》(简 称SOX法案)和《多德-弗兰克华尔街 改革和消费者保护法案》颁布之前,审 计师在一个以自我约束、同行审查为特征的环境下 执业,遵守美国财务会计准则委员会(FASB)制 定的准则,受美国注册会计师协会(AICPA)监 督。随着SOX法案出台,审计师的执业环境发生 了变化。该法案授权美国证券交易委员会(SEC) 对审计师进行监管,美国公众公司会计监督委员会 (PCAOB)应运而生。PCAOB负责“制定审计及 相关鉴证、质量控制、职业道德、独立性等方面的 准则和规则,供注册会计师事务所在编制和出具审 计报告时使用”。SOX法案还制定了一系列强制性 措施来对注册会计师行业进行改革,包括设立有关 审计师独立性、强化财务披露、刑事欺诈问责等方 面的准则。 过去15年的事实证明,相关法规以及PCAOB 等独立机构在总体上取得了成功,然而,人工智能 的应用可能会带来相当多的问题,其中包括分析工 作、战略决策等与财务环境相关的问题。《MIT斯 隆管理评论》与波士顿咨询近期的一项调查(on. bcg.com/2NNU4J1)显示, 在3,000余名参与调 查的高管人员中,约85%的受访者预期人工智能 (能够执行通常需要人类智能参与的任务的技术与 计算机系统)会为他们带来竞争优势,79%的受访 者认为人工智能将提高生产效率。 此外,美国Narrative Science公司与美国国家商业研究所(National Business Research Institute)新近发表的一份报告指出,61%的受访 企业称其去年已经运用了人工智能。相比2016年的 38%,这一比例显著增长,表明人工智能可能不再 是企业未来才会部署的技术,而是现阶段已经投入 使用的技术 (bit.ly/2CaB8zt)。在这些企业中,人工 智能主要用于预测性分析、机器学习和自然语言处 理(见图1)。

人工智能来了

除了上述受访企业的董事会,包括四大会计 师事务所在内的大型事务所也在大力投资人工智 能,以期减少在繁复的审计及其他基于数据分析 的业务上所花费的时间。近期,《福布斯》(bit. ly/2Hh3Lyq)杂志上发表的《安永、德勤和普华永 道在税务和会计领域使用人工智能》(EY, Deloitte And PwC Embrace Artificial Intelligence For Tax And Accounting)一文,进一步深入分析了这3家 事务所如何在业务实践中应用人工智能。这些组织 竞相强调其在人工智能领域的早期投资所取得的成 就以及由此带来的效率。 安永和德勤两家会计师事务所运用自然语言处 理技术进行文本审核,包括审查大量与业务部门销 售相关的合同、重新审查数以万计的客户租赁合同 以确定其符合新的会计租赁准则。上述两种工作, 原先需要花费几个月,现在则减少到几个星期。此 外,安永还应用机器学习技术帮助分析和识别潜在的欺诈交易,德勤则在税务实践中使用自然语言生 成软件,提供针对性的财务建议。 董事会和会计师事务所都需要保持创新精神, 但问题是,这些技术的进步会对SOX法案和其他改 革产生怎样的影响——这些改革提高了那些过去被 高管和审计师所忽略的领域的关注度。人们对人工 智能的依赖,会导致财务丑闻增多还是减少呢? 人工智能系统和相关算法具有的智能并不是与 生俱来的,是通过对海量重复数据进行分析并长期 发展的机器学习。英格兰及威尔士特许会计师协会 (ICAEW)近期发布的《人工智能和会计行业的 未来》(Artificial intelligence and the future of accountancy)(bit.ly/2VOs0YX)报告,就如何 把握机器智能带来的机遇勾勒了一个框架。报告提 出了3个重要问题:人工智能和会计行业的远景是什 么?人工智能与人类智能如何协同工作?会计人员 如何使用人工智能的能力? 事实上,在快速处理海量数据、保持决策的 一致性、从数据中识别复杂或者变化的模式等方 面,机器比人类更具优势。人工智能也在减少人为 差错、提供更好的预测结果方面带来很多机会,而 且,通过特定的人工智能还能提高利润。 然而,人工智能也有很多不可忽视的局限,特 别是涉及不同行业、不同地区和不同规模的公司的 财务情况时。目前,人工智能系统还不是很灵活, 并且在生成系统、准确的结果前,需要分析数百万 个数据点。机器需要通过重复的问题来进行学习, 因此,独特的会计处理和企业案例在短期内可能缺 乏可靠性,不足以用来生成准确的或有价值的数 据。过早地依赖这些结果可能会引发严重的问题。 此外,那些必须由利益相关者审查的受托责任和适 度审慎(due care)的问题,并不完全是可量化 的,也并不都是可用于分析的特定数据。当然,从 总体上看(见图2),伴随局限性和风险而来的还有 机遇。

弊端和挑战

对人们来说,一个负面影响是,随着程序效率 的提高,软件将取代人力资本。《华尔街日报》近 期发表的《新来的簿记员是个机器人》(The NewBookkeeper Is a Robot)(on.wsj.com/2EFCUJn)一文 指出,仅在2004-2014年间,大型公司财务部门的全职雇员 中位数下降了40%,从每10亿美元营业收入对应119名员工 减少到大约71名。威瑞森通讯和游戏驿站等上市公司均已在 软件方面投入巨资,将过去由额外员工承担的会计和财务职 能实现了自动化。2012-2015年,仅威瑞森通讯公司就将内 部财务部门的成本降低了21%。 伴随时间的推移,人工智能方面的风险和意外后果会 不断地披露了出来(参见“警告:人工智能在行动”)。 人工智能的主要风险,包括人类的偏见和技术本身无意造 成的错误。例如,弗吉尼亚大学一位教授开发的一款图 像识别软件,就学会了展示对女性的性别歧视观点(bit. ly/2STLb1C);在马萨诸塞大学阿默斯特分校,一名助理 教授进行的一项研究表明,人工智能系统学会了根据方言把 一些非裔美国人排除在数据集之外(bit.ly/2XKq3OF)。目 前人工智能机器学习系统存在很多直接偏差,上述例子仅是 其中之二。如果产生的偏差涉及利润增长、达到或超出预测 结果、提升股东回报等事项,又将带来什么后果?在SOX法 案下,一些可能招致难以预测后果的法律问题也开始浮出水面 。

不可预测的后果

在这些法律问题中,其中之一就是谁将最终为人工智能 做出的决定负责。此前,瑞士艺术家们发明了一个自动网上 购物机器人,让它每周消费100美元的比特币,以此作为一个 艺术展的一部分。这个程序的任务是在暗网市场上购物,这 一市场既售卖合法物品也有非法物品。机器人购买的物品, 包括一顶装有隐藏照相机的棒球帽、一双耐克篮球鞋、一个 仿冒的路易威登手袋、200支香烟、一套消防队用的万能钥匙 和10颗摇头丸(bit.ly/2Cbo6Sg)。艺术家和机器人,谁应 该为购买非法物品负责呢? 会计欺诈和财务丑闻方面,也面临着这类有待解决的 问题。当欺诈行为未被及时发现,或更有甚者,系统像人类 一样学会共谋,我们是否要对机器人处以罚金或将其投入监 狱?即使在人工智能系统履行决策分析职能的情况下,人类 是否最终还要承担最高标准的受托责任及适应审慎? 目前,美国司法体系仅因软件开发者的过失或已预见的 即将发生的伤害,判定软件开发员承担人身伤害责任。Jones v. W+M自动化公司的一名工人被机器人装载系统严重伤害, 但因制造商(被告)遵守了相关规定,所以被判定不承担责 任(tcrn.ch/2C8nzRh)。随着人工智能学习技术的应用, 人类可能不必为未能发现欺诈和不正当行为而负责,也不会 因为应用这类软件造成可预见的伤害。现行侵权法主张这些 系统的研发者和购买者无须承担法律责任。 而在存在欺诈的情况下,由于人工智能不断地进行自主 适应与学习,法庭将不得不依据最新的或扩大的代理法,来 裁定使用者自身是否应该为人身伤害案件负责。现有的代理 法可能并不适用。代理法的主旨是委托人授权给代理人。

可解释性

2018年,哈佛大学教授Margo Seltzer警告称,如果计算机 模型将观察结果误读为原因,会导致人工智能失灵。她援引了一 项针对75万名肺炎患者所进行的计算机研究,计算机模型得出的 一个结论是,哮喘病人死于肺炎的可能性较小——数据显示哮喘 使他们免受其害。Seltzer对这个危险的误读进行了解释:“同时 患有哮喘和肺炎的患者来到急诊室,会比没有得哮喘的患者得到 更多的重视,因此更有可能被医院接收治疗。”算法不了解更加 积极的治疗方式。这种问题被称作“可解释性”。

机器人学会说谎

2009年,瑞士洛桑进行了一项实验,给1000个小机器人分 别装上传感器和蓝灯,并通过编程让它们寻找优势资源(“食 物”)。某个机器人找到食物后,就会亮起蓝灯,示意其他机 器人过来。寻找、停留和发出信号会得正分,而在负面刺激物 (“毒物”)附近徘徊,或被其他机器人排挤而远离食物会得负 分。每次实验后,优胜的机器人进入下一轮。经过500轮的测试, 60%的机器人逐步发生演变,它们找到优势资源时不再亮灯,而 是将其据为己有,33%的机器人“演变为实际上在通过对灯光的 排斥来寻找说谎者。这与编程初衷背道而驰”。

致命的自动驾驶

2018年,一辆优步SUV越野车在无人驾驶模式下行驶,车上 有一名安全员,在车辆的传感器检测到行人的情况下,却没有采 取措施,造成了全球首例自动驾驶车辆导致行人死亡事故。根据 美国国家运输安全委员会(NTSB)的初步报告,优步的无人驾驶 模式导致沃尔沃厂家安装的自动制动装置失效。 —Michael Castelluccio

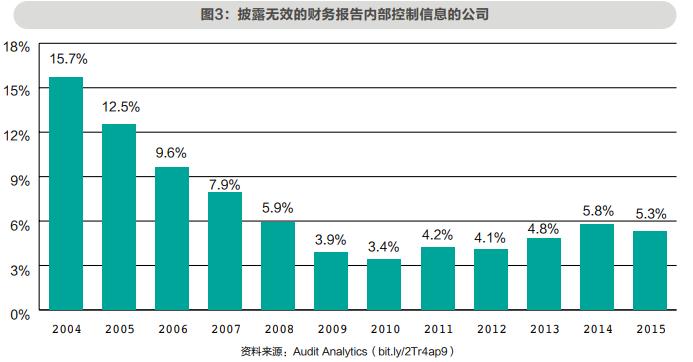

其以自己的名义与第三人实施民事行为。在这段代理关系存续 期间,如果代理人给第三人造成任何伤害和损伤,委托人被认 定是最终责任人。有观点认为,一旦人工智能软件开始独立思 考或自己决策,法律意义上的代理关系就会变得紧张,抑或完 全被打破。倘若如此,哪一方会被认定承担责任呢? 最为重要的是,有些人会问,当人们再次变得自满,SOX 法案的影响是否已经开始逐渐减弱?或者说,人工智能的实 施是否减少了对内部控制等重要的内在因素的关注? Audit Analytics机构进行一项名为《SOX法案对财务重述的影响》 (The Impact of SOX on Financial Restatements)(bit. ly/2Tr4ap9)的研究表明,在SOX法案404条款实施后的几年 里,披露无效的财务报告内部控制(ICFR)信息的公司大幅减 少,但最近这个比例又开始回升(见图3)。 毫无疑问,人工智能应该而且必将在公司财务和会计部门 以及注册会计师事务所发挥巨大作用。但是,人工智能如果会 产生种族歧视、性别歧视或其他偏见,是否也会为了获得积极 的结果而滋生贪婪或在道德上做出妥协?技术发展日新月异, 审计师、董事、高级职员以及首席执行官都必须与时俱进,在 将人工智能作为一种具有成本效益的大胆尝试或节省人工审核 时间的工具时,每个人都应该始终保持职业怀疑态度。 根据公众公司会计监督委员会第230节第7条(AU Section 230.07)审计准则,在工作中履行应有的职业审慎要求审计师 秉持职业怀疑态度。该条款要求,“职业怀疑态度包括质疑的 思维方式和对审计证据的批判性评价。审计师运用注册会计 师职业要求的知识、技术和能力,秉持诚信正直的态度,勤 勉地收集并客观评价证据”。问题是,注册会计师们是在人 工智能审查过(但实际上却没有审查)的信息和证据的基础 上出具审计意见,这些审计意见的客观性仍需质疑。 例如,ICAEW在一份报告中提出了许多正面的理由和例 证,支持人工智能在会计领域推广使用,但其中也着重强调 了人机协作会带来更好效果的例证。无论机器系统变得多么 智能,专业人士、监管机构和整个社会都必须认识到,审计 师和首席执行官的批判性眼光将始终在欺诈防范中发挥重要 作用。 审计师、会计师和高管们必须为金融市场中不断出现 的人工智能做好准备。这些准备包括了解人工智能的基本知 识、人类还能够且应该发挥的作用、人工智能带来的风险与 机遇。为避免SOX法案在实施后出现重大倒退,我们必须针 对性地进行自我教育。

资料来源:Audit Analytics(bit.ly/2Tr4ap9) Mark A.

(以上信息来自CMA官网)

CMA学习咨询电话:0532-88889889 15908998386

地址:青岛市崂山区香港东路23号D217现代职业发展研究院CMA研究中心